最大限制(Max Tokens)

什么是最大限制(Max Tokens)?

OpenAI 语言模型通过将文本划分为标记(token)来处理文本,这些标记可以是单个单词或字符组。

例如,单词 fantastic 将被拆分为标记:fan, tas 和 tic,而较短的单词例如 gold 将被视为单个标记。许多标记以空格开头,例如 hi 和 greetings。

单个 API 请求中处理的标记(token)数取决于输入和输出文本的长度。最大限制(Max Tokens)就是 GPT 平台允许单个 API 请求中处理内容(文本提示和所生成响应内容的组合长度)的最大标记(token)数。

一般来说,一个标记(token)大致相当于 4 个字符或 0.75 个单词的英文文本。

- 1 个标记(token) ~= 4 英文字符

- 1 个标记(token) ~= ¾ 单词

- 100 个标记(token) ~= 75 单词

或者

- 1-2 句子 ~= 30 个标记(token)

- 1 段落 ~= 100 个标记(token)

- 1,500 单词 ~= 2048 个标记(token)

注意:文本提示和生成的响应内容的组合长度不得超过模型的最大上下文长度,通常为 4096 个标记(token)或大约 3000 个单词,下面的表格给出了不同模型的最大上下文长度限制。

统计计数基于 1,000 个标记(token)为基数。标记(token)可以被认为是单词的一部分,1,000 个标记(token)大约是 750 个单词。

比较不同模型的标记(token)限制

在使用 GPT-3.5 和 GPT-4 等高级语言模型时,了解它们的标记(token)限制至关重要,因为这些约束会影响生成内容的范围和质量。

在下表中,我们提供了每个组中各种模型的最大上下文长度限制的易于参考的比较。这些信息将帮助您在选择最适合您的特定需求和任务的模型时做出明智的决策,从而优化语言生成体验。

| 模型组 | 模型 | 最大上下文长度 |

|---|---|---|

| GPT-4 | GPT-4 | 8K |

| GPT-4-32K | 32K | |

| GPT-3.5 | GPT-3.5-turbo | 4K |

| GPT-3.5-turbo-16k | 16K |

调整最大限制(Max Tokens)

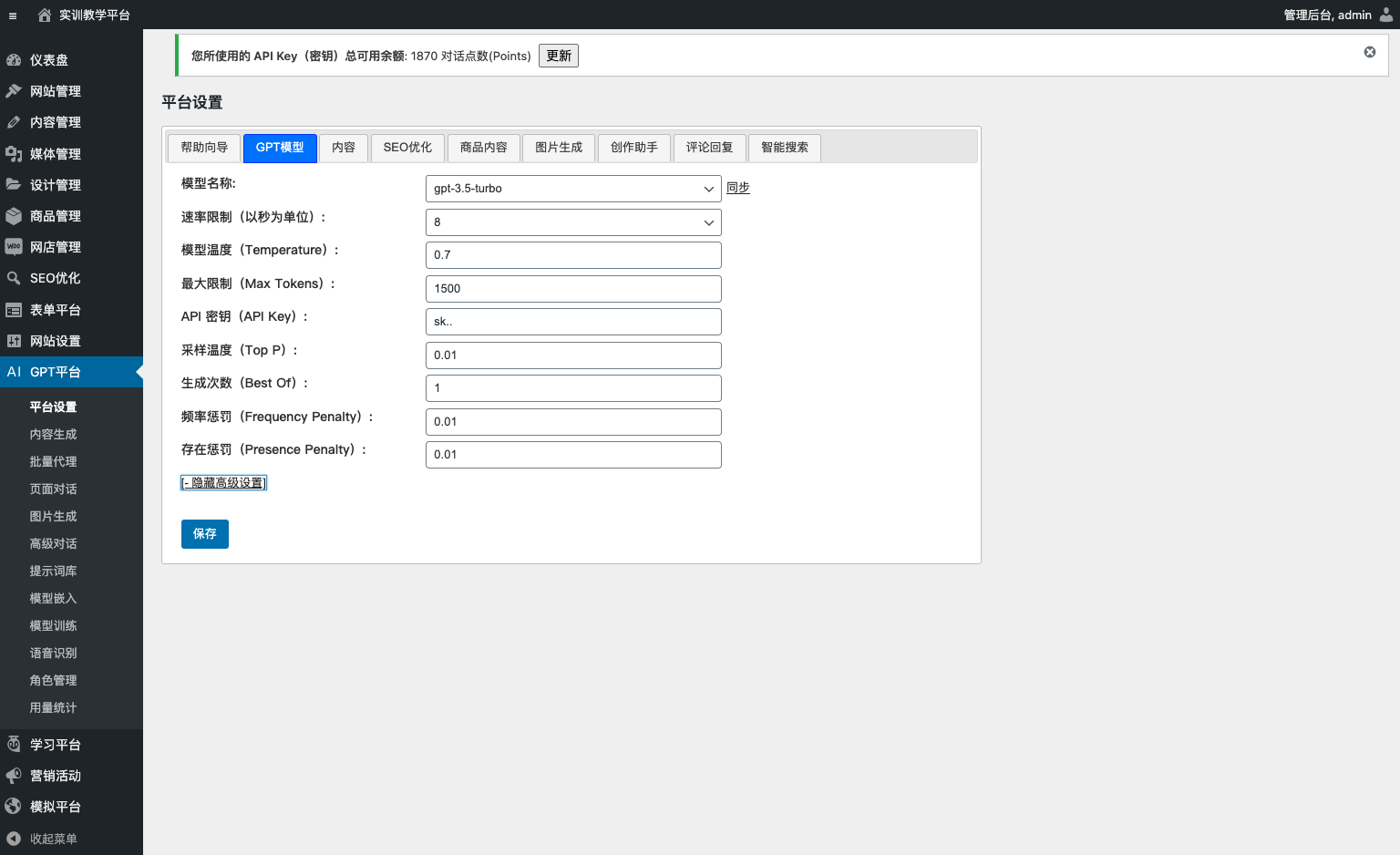

平台使用 1500 作为默认的最大限制(Max Tokens)值。

但是,您可以从“GPT 模型”选项卡的“最大限制(Max Tokens)”字段中进行更改。

修改步骤:

- 单击“平台设置”页面,然后查找“GPT 模型”选项卡。

- 在“最大限制(Max Tokens)”字段中输入新值。

- 单击“保存”按钮以保存更改。

最大限制(Max Tokens)值对生成内容的影响

最大限制(Max Tokens)参数是用于控制在对 GPT 模型的单次调用中处理内容(文本提示和生成的响应内容的组合长度)的最大标记(token)数。

标记(token)是 GPT 模型对自然语言处理中的离散含义单位。

在 GPT 模型中,每个标记(token)都表示为一个唯一的整数,所有可能的标记(token)的集合称为词汇表。

例如,在 GPT-3 模型里,词汇量为 175000 个标记(token)。

使用 GPT 模型生成文本时,模型会接收提示(也称为“种子文本”),这是生成文本的起点。然后,模型使用此提示生成一系列标记(token),一次生成一个标记(token)。

最大限制(Max Tokens)参数用作模型输出的限制,如果模型生成非常长的文本,通过设置此参数,您可以控制生成文本的大小。

此参数在不同情况下很有用,例如:

- 当您想要生成特定数量的文本时,无论模型具有多少上下文。

- 当您想要将生成的文本限制为特定大小,-以适应特定格式或应用程序时。

- 当您想要提高模型的性能时。

注意:将“最大限制(Max Tokens)数”参数设置得太低可能会阻止模型充分表达其想法或完成其想法。它还可能导致句子不完整或语法不正确。